在居然装饰与每平每屋·设计家“数字+”产品发布暨“寻找国民好设计”设计挑战赛(华北区)启动新闻发布会上,阿里巴巴每平每屋平台业务负责人、每平每屋设计家CEO石梵正式发布了每平每屋与淘系技术合作自研的AI视频建模技术及其应用产品Object Drawer。Object Drawer是业界首个基于神经渲染的3D建模产品,推理速度相较于nerf算法提升了1万倍。

基于此项技术,消费者不需要依赖特定设备,只需要手机环绕目标商品进行视频拍摄,就可以完成自动重建,所生成的三维建模效果达到高精模型还原度,还能够把目标商品放到自己家的真实户型中进行展示。

而这个家居黑科技从何而来?背后工具支撑有多强大?让我们一探究竟。

VR/AR赛道崛起 家居家装3D建模需求暴涨

元宇宙源于1992年尼尔·斯蒂芬森的《雪崩》,这本书描述了一个平行于现实世界的虚拟世界,Metaverse,随着VR/AR应用的发展,在现实世界家装家居领域,正在大量地运用VR、3D、虚拟现实等技术,云化的3D拍摄素材库、场景库已经成为商家的数字化基建的重要环节,经营者希望解脱了拍摄策划、3D创作的困扰,云素材能够信手拈来,随时开拍。另一方面,市场上家居家装商品3D建模需求持续增加,家居家装商品建模需求可能达到现在的100倍以上。

目前市面上的商品3D建模主要依赖于手工建模,建模时长需要几小时甚至几天时间,费用动辄数百到数千元,不仅对建模环境、拍摄设备提出了诸多要求,为了提升目标商品的形状、纹理、材质的展示细节,还需要大量人工作业进行高精度还原和细节修复。

关键核心技术突破 推理速度提升10000倍

近几年,神经渲染技术正在飞速发展。Google初代的NeRF及其衍生技术利用神经隐式表达来存储场景的物理几何以及材质纹理信息,端到端的优化渲染效果,但在实际应用中仍存在许多问题,主要包括:第一,推理速度、训练速度慢,1帧高清图推理时间超过50秒,一个物体的建模时间长达2天以上。第二,细致纹理无法还原。第三,部分视角渲染效果不理想。第四,无法直接导入图形学工具,不支持显式使用,例如CAD场景搭配设计;此外,由于只能还原拍摄场景的光照也使得NeRF模型无法支持环境光照变化的场景应用。

而每平每屋与淘系技术共研AI视频建模技术及其承载产品Object Drawer通过优化网络结构,探索几何先验,预存部分信息,在保证渲染质量的前提下,其推理速度可以达到每秒200帧,在手机上可达到每秒30帧,从而实现了实时高清可交互的三维模型,且相比NeRF算法推理速度提升了10000倍。模型的训练时间从2天压缩到仅需要4小时,模型大小仅需要20M,同时,对于任意视角查看,商品3D模型都达到实拍照片的展示效果,实现了3D建模一直追求的自动高精度还原。Object Drawer不需要依赖特定设备,只需要手机环绕目标商品进行视频拍摄,就可以完成AI人工智能的自动重建,所生成的3D建模效果达到高精模型还原度。目前,这项技术已经面向手淘、天猫部分家居家装商家开放。

攻克复杂光照迁移、纹理细节还原等难题

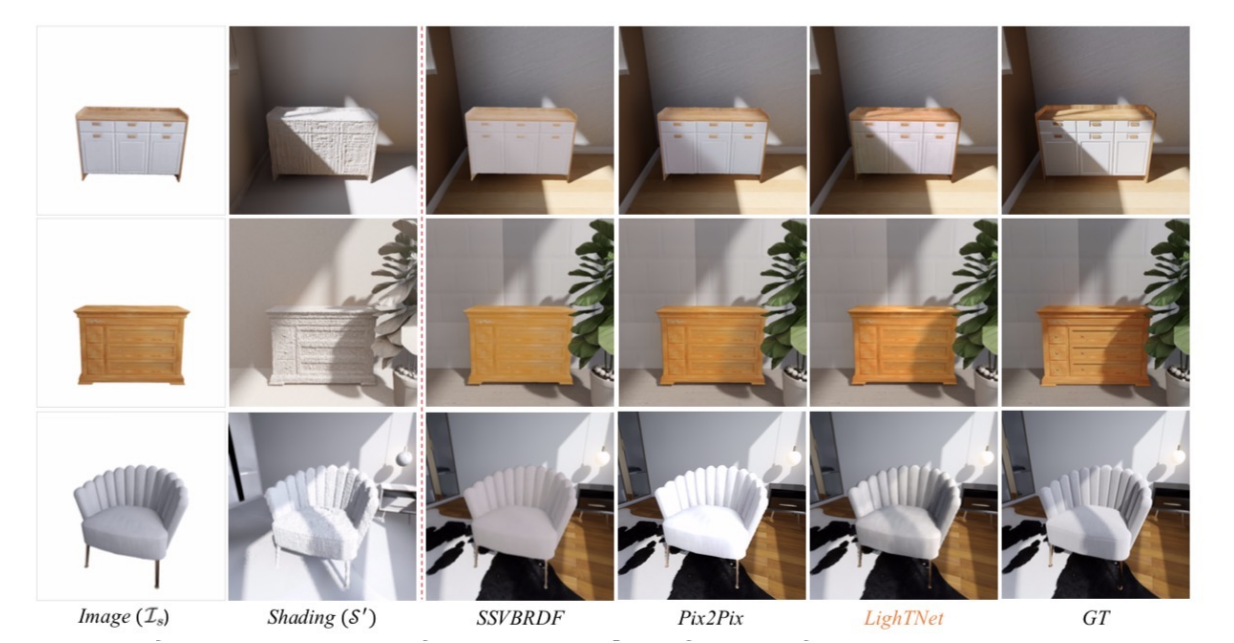

为了反应物理渲染作用于3D粗模型的光照效果,如反射,阴影等,Object Drawer将物理渲染反应在物体上的逼真光照效果迁移到神经渲染生成的物体视角图上,通过融合得到具有光照效果的神经渲染结果,进一步用得到的带有光照效果的高清合成图替代物理渲染结果中的粗模投影以实现逼真的场景渲染效果。在实验数据的结果表明,Object Drawer能够适应各种复杂光源条件以及细节的阴影效果的迁移,视觉效果远超其他替代方案。

(Object Drawer建模时不同光照迁移效果)

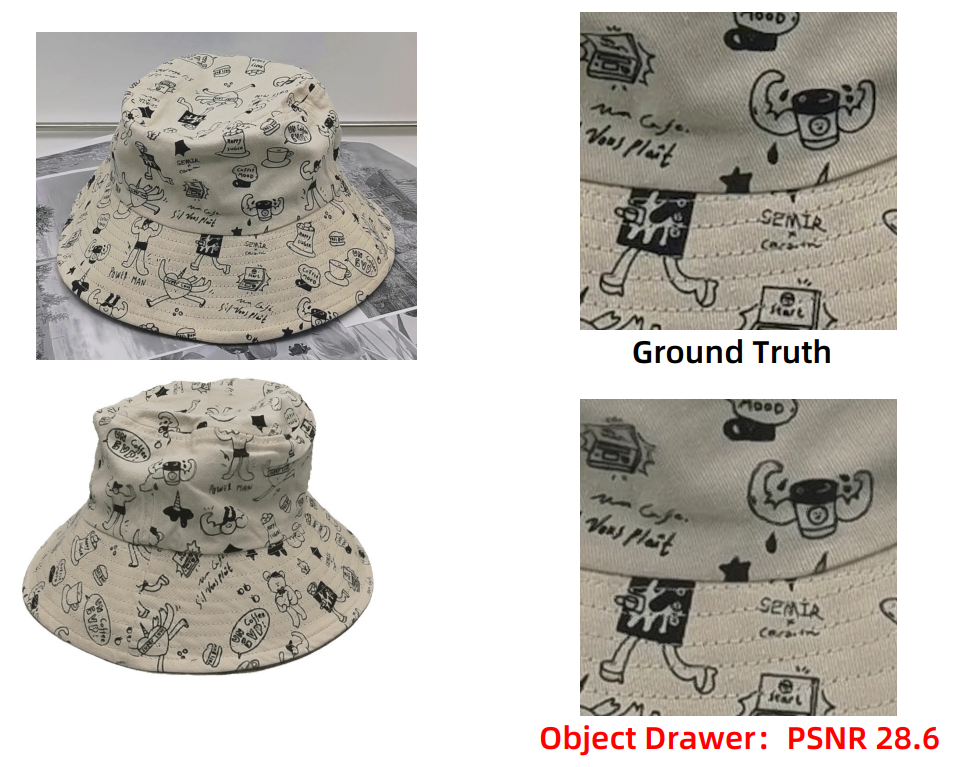

在还原纹理细节方面,对于家居家装商品的模型来说,纹理细节还原度非常重要,通常需要达到照片级的还原才能支持实际渲染相关产品。Object Drawer优化了模型表达,在大幅度加速模型训练时间的同时,第一次做到了高清精细纹理还原,如布料线条等细节都能清晰可见。

(模型与真实商品纹理细节对比图)

每平每屋与淘系技术携手推出基于AI视频建模技术的应用产品Object Drawer对神经辐射场技术进行了全面的改进和升级,实现了家居家装商品自动化高精度建模流程,未来,每平每屋作为阿里巴巴旗下家居家装赛道的创新业务,会持续加大科研技术投入,从「商品模型-户型-设计」及其他各个步骤,帮助商家、设计师、消费者降低3D场景创作的门槛,将科技注入家装家居和居住全链路的每一个环,以科技优化每个人对居住空间的体验、体感与审美,构建数智化的全新居住模式。